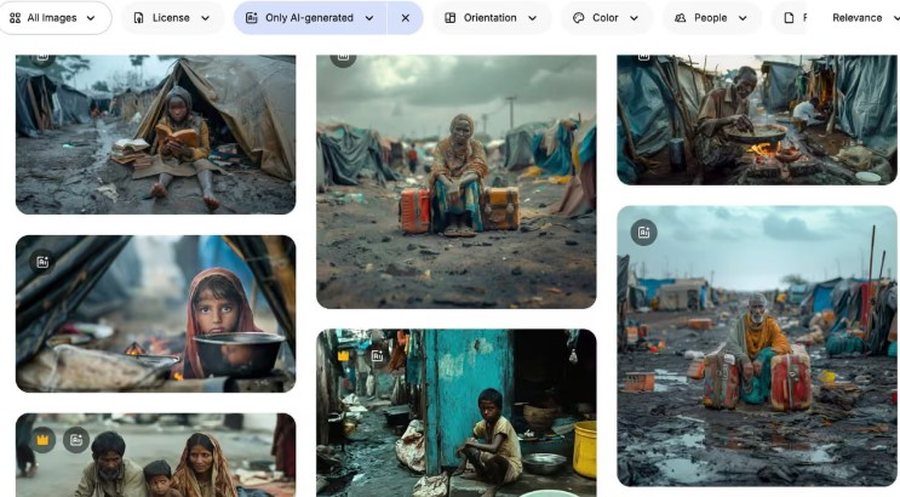

Fotografi që tregojnë fëmijë të uritur, gra të dhunuara apo skena varfërie të thellë po përhapen me shpejtësi në faqet e fotove “stock” dhe po përdoren gjithnjë e më shumë nga OJQ-të e shëndetit global dhe shumë ekspertë po paralajmërojnë për një epokë të re të asaj që quhet “poverty porn”.

“Është bërë e zakonshme. Shumë organizata po i përdorin ose po eksperimentojnë me to,” tha Noah Arnold nga organizata zvicerane Fairpicture, e cila promovon përdorimin etik të imazheve në zhvillimin global.

Sipas studiuesit Arsenii Alenichev nga Instituti i Mjekësisë Tropikale në Antwerp, këto imazhe imitojnë “gramatikën vizuale të varfërisë”; fëmijë me pjata bosh, tokë e plasaritur, fytyra të trishtuara, klishe raciale. Ai ka mbledhur mbi 100 imazhe të krijuara nga inteligjenca artificiale që janë përdorur nga individë apo organizata në fushata kundër urisë apo dhunës seksuale.

Në disa prej tyre shfaqen fëmijë që qajnë në ujë me baltë apo një vajzë afrikane me fustan dasme dhe lot në faqe; skena që, sipas Alenichev, përbëjnë “poverty porn 2.0”.

Arsyeja pse këto imazhe po përhapen? Kostoja e ulët dhe mungesa e nevojës për leje apo miratim. “Është shumë më lirë dhe s’ke nevojë të merresh me pëlqime apo privatësi,” tha ai.

Në faqe si Adobe Stock dhe Freepik shfaqen dhjetëra foto të tilla me përshkrime si “fëmijë aziatikë në lumë me mbeturina” apo “vullnetar i bardhë që ndihmon fëmijë të zinj në fshat afrikan” të cilat shiten për rreth 60 paund.

“Janë thellësisht raciste. Këto s’duhej të lejoheshin kurrë,” shtoi Alenichev.

CEO i Freepik, Joaquín Abela, tha se përgjegjësia bie mbi përdoruesit, jo platformat.

“Nëse konsumatorët duan imazhe të tilla, s’kemi ç’të bëjmë, është si të përpiqesh të thash oqeanin,” u shpreh ai.

Në vitet e fundit, edhe organizata të njohura kanë përdorur imazhe të krijuara nga AI.

Në 2023, Plan International publikoi një video kundër martesave të hershme me imazhe të gjeneruara nga AI që tregonin vajza të rrahura e të martuara me burra më të mëdhenj në moshë.

Edhe OKB-ja vitin e kaluar postoi një video me “rindërtime” të dhunës seksuale në luftë, përfshirë një grua burundiane që rrëfente përdhunimin e saj nga tre burra gjatë luftës civile, video që u fshi menjëherë pas kritikave.

Një zëdhënës i OKB-së pranoi se materiali “përfaqësonte përdorim të papërshtatshëm të AI-së” dhe se “mund të rrezikonte integritetin e informacionit duke përzier të vërtetën me të sajuarën”.

Ekspertët paralajmërojnë se këto imazhe, përveç se përforcojnë stereotipe raciale, mund të ndikojnë edhe në mënyrën si trajnohen modelet e reja të AI, duke riprodhuar paragjykimet ekzistuese në përmasa më të mëdha.

“Është e trishtueshme që lufta për përfaqësim etik të njerëzve në varfëri tani është zhvendosur edhe te ajo që s’ekziston, te imazhet e krijuara nga kompjuteri,” tha konsulentja e komunikimit Kate Kardol.

Një zëdhënës i Plan International tha se organizata tashmë ka miratuar udhëzime që ndalojnë përdorimin e AI për të portretizuar fëmijë me aftësi ndryshe dhe se videoja e vitit 2023 kishte për qëllim të mbronte “privatësinë dhe dinjitetin e vajzave reale”. Adobe nuk komentoi mbi rastin.